swoole应用的负载均衡需借助nginx、HAProxy等反向代理实现流量分发,高可用则通过多实例部署、健康检查、故障转移及redis、数据库、消息队列等外部存储实现状态同步,确保服务持续可用。

Swoole本身并不是一个负载均衡器,它是一个高性能的php异步并发框架,更像一个应用服务器。所以,要实现Swoole应用的负载均衡,我们通常需要借助外部的专业工具或服务来完成流量分发。至于高可用,那是在负载均衡的基础上,通过多实例部署、故障转移和状态同步等手段,确保服务即使在部分组件失效的情况下也能持续对外提供服务。

解决方案

要为Swoole应用做负载均衡,核心思路是让外部流量入口将请求均匀或按策略地分发到多个Swoole实例上。

常见的做法是使用成熟的反向代理或负载均衡器:

- Nginx: 这是最常见的选择,配置简单,性能也足够。无论是http请求(

proxy_pass

)还是TCP/udp协议(

stream

模块),Nginx都能胜任。它能做简单的轮询、IP Hash等分发策略。

- HAProxy: 对于更复杂的负载均衡策略,如基于权重、最少连接等,以及更精细的健康检查,HAProxy是更专业的选择。它在TCP和HTTP层面的代理都非常强大。

- lvs (linux Virtual Server): 如果流量巨大,对性能要求极致,LVS是操作系统层面的解决方案。它在数据链路层进行转发,性能损耗极低,但配置相对复杂。

除了这些,如果你的架构更偏向微服务,还可以引入服务发现机制(如consul、etcd、zookeeper),让Swoole实例启动时注册自己,负载均衡器或客户端通过服务发现获取可用实例列表,再进行分发。当然,也有一些更高级的玩法,比如在客户端直接实现负载均衡逻辑,但这通常只适用于特定场景,增加了客户端的复杂性。

Swoole高可用方案具体怎么落地?

高可用不只是部署多个实例那么简单,它是一个系统性的工程,需要考虑方方面面。

首先,最基础的就是多实例部署。你至少需要两个或更多的Swoole实例,运行在不同的服务器上,或者至少是不同的端口上,这样即使一个实例挂了,其他实例还能继续提供服务。当然,这些实例前面得有个负载均衡器来分发流量。

其次,心跳检测与健康检查至关重要。负载均衡器需要能实时知道哪些Swoole实例是健康的、能正常响应请求的。Nginx、HAProxy都支持对后端服务进行健康检查,比如定期发送HTTP请求或TCP连接探测。如果一个实例长时间没有响应,负载均衡器就会把它从可用列表中移除,不再向它发送流量,直到它恢复正常。

再者,故障转移(Failover)是高可用的核心。当一个Swoole实例宕机时,负载均衡器能够自动将流量切换到其他健康的实例上。这个过程应该是无缝的,用户几乎感受不到服务中断。

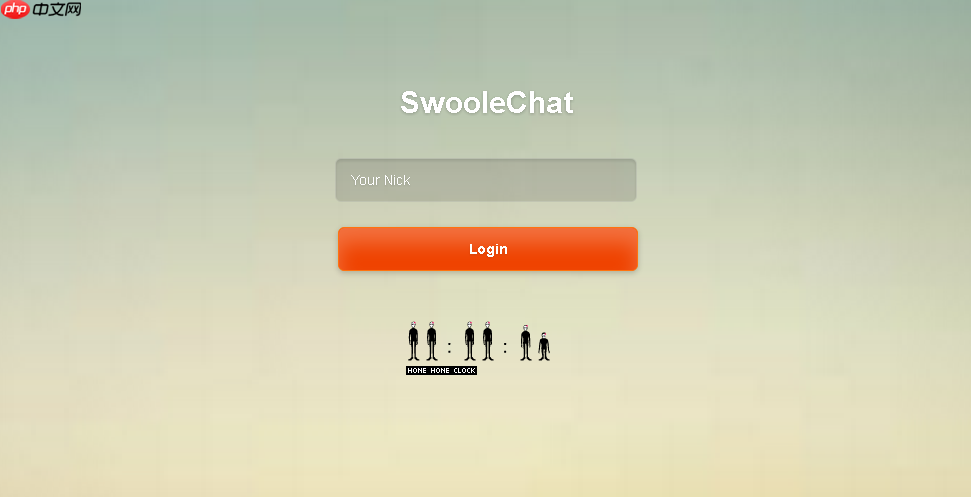

对于Swoole应用,特别是一些需要保持状态的应用(比如websocket长连接、聊天室等),状态持久化和同步是高可用的一大挑战。如果一个用户连接到SA,但A挂了,用户重连到B,如果会话状态没有同步,用户体验就会很糟糕。这时候,通常会借助外部存储来解决,比如:

- redis: 广泛用于存储会话信息、用户在线状态、消息队列等。Swoole实例将状态写入Redis,其他实例可以从Redis读取,实现状态共享。

- 数据库: 对于更持久化的数据,数据库的Master-Slave或集群方案是必须的。

- 消息队列(如kafka、rabbitmq): 用于跨实例的事件通知、数据同步或广播。比如,一个用户在实例A上发送了消息,可以通过消息队列通知所有其他实例,再由它们推送到各自连接的客户端。

最后,别忘了进程守护。Swoole进程可能会因为各种原因异常退出,使用

Supervisor

、

systemd

这类进程管理工具可以确保Swoole进程即使崩溃也能被自动拉起,减少人工干预。

在使用Nginx作为Swoole反向代理时,有哪些需要注意的坑?

Nginx是Swoole反向代理的“老搭档”了,但有些地方确实需要留意,不然容易踩坑。

一个常见的点是长连接的保持。如果你的Swoole服务是HTTP服务器,并且使用了

keep-alive

,或者直接是WebSocket服务,Nginx的配置需要特别注意。对于WebSocket,你得加上

proxy_set_header Upgrade $http_upgrade; proxy_set_header Connection "upgrade";

这两行,告诉Nginx这是个升级协议的请求,别把它当成普通的HTTP短连接处理了。不然,WebSocket连接就建立不起来。

客户端真实IP的传递也是个坑。默认情况下,Nginx作为反向代理,Swoole获取到的客户端IP会是Nginx的IP。为了获取真实客户端IP,你需要在Nginx配置中添加

proxy_set_header X-Real-IP $remote_addr;

和

proxy_set_header X-forwarded-For $proxy_add_x_forwarded_for;

,然后在Swoole应用里从HTTP头中获取这些值。

超时设置也是个容易被忽略的细节。Nginx有

proxy_connect_timeout

、

proxy_send_timeout

、

proxy_read_timeout

等,Swoole也有自己的

heartbeat_idle_time

、

heartbeat_check_interval

等配置。如果两边的超时设置不匹配,可能会出现连接过早断开或僵尸连接的问题。比如,Nginx的读取超时设置得比Swoole的心跳间隔短,就可能导致Nginx在Swoole还没发心跳前就断开了连接。

对于大文件上传,Nginx默认的

client_max_body_size

可能只有1MB,如果你的Swoole应用需要处理大文件上传,记得把这个值调大。

此外,如果你用Nginx代理Swoole的TCP服务器(非HTTP),你需要使用Nginx的

stream

模块。这块的配置和HTTP代理有所不同,主要是处理纯TCP流,不解析HTTP协议。

Swoole如何处理长连接下的状态同步和会话管理?

长连接下的状态同步和会话管理是Swoole高可用架构中比较复杂的部分,尤其是当你有多个Swoole实例时。

最理想的状态是无状态设计,即每个请求或每个消息都包含所有必要的信息,Swoole实例不需要维护任何会话状态。这样,请求可以被任意一个Swoole实例处理,负载均衡就非常简单。但对于长连接应用,比如聊天室、在线游戏,这几乎是不可能的,因为用户连接本身就是一种状态。

所以,我们通常会引入外部共享存储来解决这个问题。

- Redis是首选,因为它高性能、支持多种数据结构,并且可以持久化。Swoole实例可以将用户ID与

fd

(文件描述符)的映射关系存储在Redis中,或者用户的在线状态、聊天室成员列表等。当一个用户通过实例A连接,他的

fd

和用户信息存在Redis里;如果实例A挂了,用户重连到实例B,实例B可以从Redis中读取该用户的状态信息,并重新建立连接上下文。

- Swoole table虽然是共享内存,性能极高,但它只在单个Swoole实例内部共享。这意味着,如果你有多个Swoole实例,

Swoole Table

里的数据是各自独立的,无法跨实例共享。所以,它不适用于跨实例的状态同步,除非你只运行一个Swoole实例(这显然不符合高可用要求)。它的价值在于,可以在单个Swoole实例内部的多个Worker进程之间高效共享数据,减少进程间通信开销。

另外,消息队列在长连接状态同步中扮演着重要角色。当一个事件发生(比如用户A发消息),如果用户B连接在另一个Swoole实例上,实例A可以将这个消息发布到消息队列,所有订阅了该主题的Swoole实例(包括实例B)都能收到。实例B收到后,再将消息推送到连接在它上面的用户B。这样,就实现了跨实例的消息广播和状态同步。

最后,Sticky Session(会话粘滞)是负载均衡器提供的一种功能。它尝试将同一个客户端的请求(或长连接)始终路由到同一个后端服务器上。这在一定程度上可以简化状态管理,因为你不需要频繁地同步状态。但它的缺点也很明显:

- 负载不均: 某些服务器可能会因为承载了大量“粘滞”用户而负载过高,而其他服务器则比较空闲。

- 单点故障: 如果被粘滞的那个Swoole实例挂了,所有连接到它的用户都会断开,直到负载均衡器将他们重定向到其他实例。这与高可用的目标有所冲突。

因此,虽然Sticky Session能解决部分问题,但在设计高可用的Swoole长连接服务时,更推荐采用无状态设计结合外部共享存储和消息队列的方案,这样可以更好地实现弹性伸缩和故障恢复。