本文主要介绍了google在cikm 2021上发表的一篇文章,该文章探讨了如何通过对比学习解决推荐系统中的长尾问题。

论文标题为《Self-supervised Learning for Large-scale Item Recommendations》,论文链接为:https://www.php.cn/link/f49a2479665b3bd13ec08d5d1a8bbe4c。

首先,让我们定义一下长尾效应:20%的热门商品占据了80%的曝光量,而剩下的80%的小众、长尾商品则很少获得曝光机会,因此在训练样本中显得稀少且弱势。

传统的推荐模型通常迎合大多数用户的需求,由于长尾商品曝光机会少,难以满足小众兴趣,这对成熟的生态系统不利,阻碍了用户增长。

举个例子:某些原本不受重视的销量小但种类多的商品,由于总量庞大,其累积收益可能超过主流商品。在这种情况下,算法挖掘小众兴趣的能力变得至关重要。

对于样本不均衡的问题,对比学习通常会想到数据增强(data augmentation)。对比学习的核心是通过数据增强构建正负样本变体,倾向于无监督学习,学习一个优秀的特征提取器。在推荐系统中引入对比学习用于去偏(debias),解决“少数人群+冷门物料,标注样本少”的问题,从逻辑上是可行的。

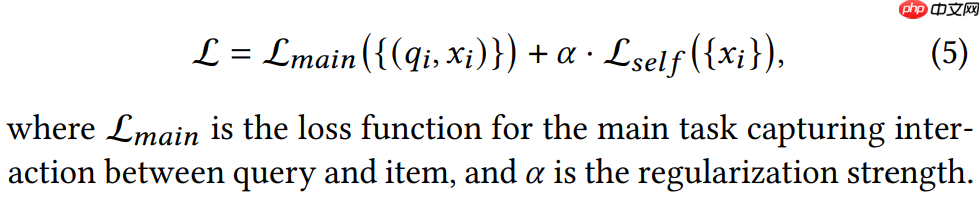

《Self-supervised Learning for Large-scale Item Recommendations》利用对比学习辅助训练双塔召回模型,旨在使item tower对冷门、小众商品也能学习出高质量的embedding,从而改善内容生态。从公式上看,可以理解为将对比学习的损失(loss)作为主任务损失的一个正则项。

论文解读中,小Q认为论文中有两个核心技术点:一个是对比学习部分,另一个是联合训练部分。

3.1 在对比学习数据增强部分,论文提出了对于商品特征的数据增强分为两个步骤:Masking和Dropout。其中Masking是采用默认embedding随机掩盖一些输入特征,而Dropout则是简单地随机丢失一些输入特征。

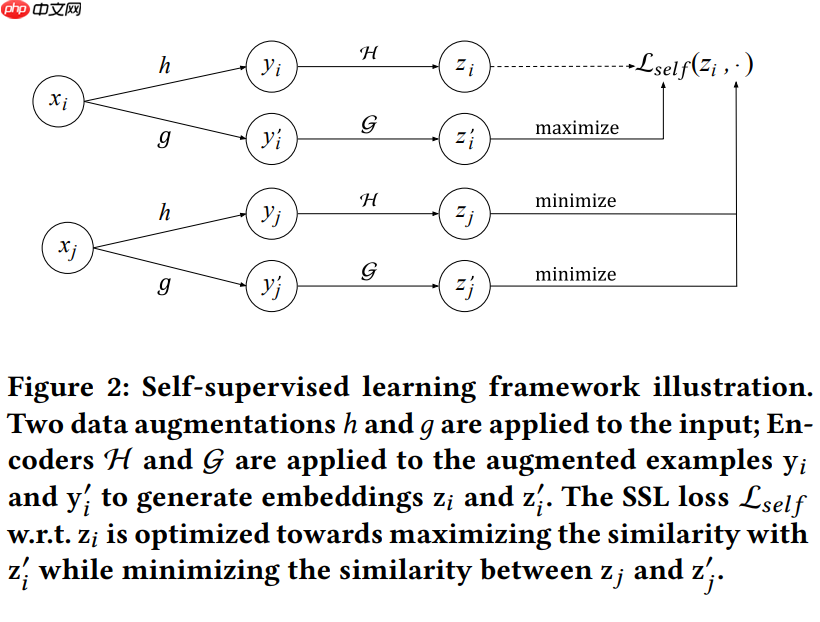

3.2 论文定义了一个基准方法Random Feature Masking(RFM),采用互补masking模式,即将特征集拆分为两个互斥特征集,构建为两个扩展变体。具体来说,将特征集随机分成两个不相交的子集。大致结构如下:

对于某个商品xi,随机抽取一半的特征h,得到变体yi,再经过Encoder H,得到向量zi;保留剩下的另一半特征g,得到变体yi’,再经过Encoder G,得到向量zi’。来自同一个商品xi的两种变体对应的embedding zi和zi’,两者之间的相似度应该越大越好。按照同样的方法,另一个商品xj,用一半特征h得到变体,再经过Encoder H得到yj;用另一半特征g,得到变体,再经过Encoder G得到yj’。来自不同商品的变体对应的embedding,两者之间的相似度应该越低越好。

3.3 论文基于信息论中的互信息,提出了Correlated Feature Masking(CFM)方法。这个方法在每个batch进行训练时,先会随机选取一个特征f_seed,然后选择topn(n为商品的特征总数的一半)构建一个特征集作为变体。

3.4 关于为什么采用互补masking模式构建对比学习的变体,以及为什么采用互信息高的特征集会比随机masking效果好,论文中有这样一段描述:

For instance, the SSL contrastive learning task may exploit the shortcut of highly correlated features between the two augmented examples, making the SSL task too easy.

从字面上看,随机masking可能会将一些高度相关的特征分到两个变体中,使得对比学习任务变得过于简单。为了增加难度,采用互补masking模式。进一步解释,随机masking可能使得模型在对比学习过程中,通过关联度较高的特征来“猜”出被mask的特征,使得任务训练变得简单。

举个例子,假设商品有品类、品牌、产品系列、价格等特征,如果“品牌”被拆分到变体h中,“产品系列”被拆分到变体g中,看上去两个变体不同,但两个特征包含的隐信息其实相差不大,最终两个变体的embedding太容易相似,达不到训练模型的目的。采用互补masking模式是为了保证变体的差异性。

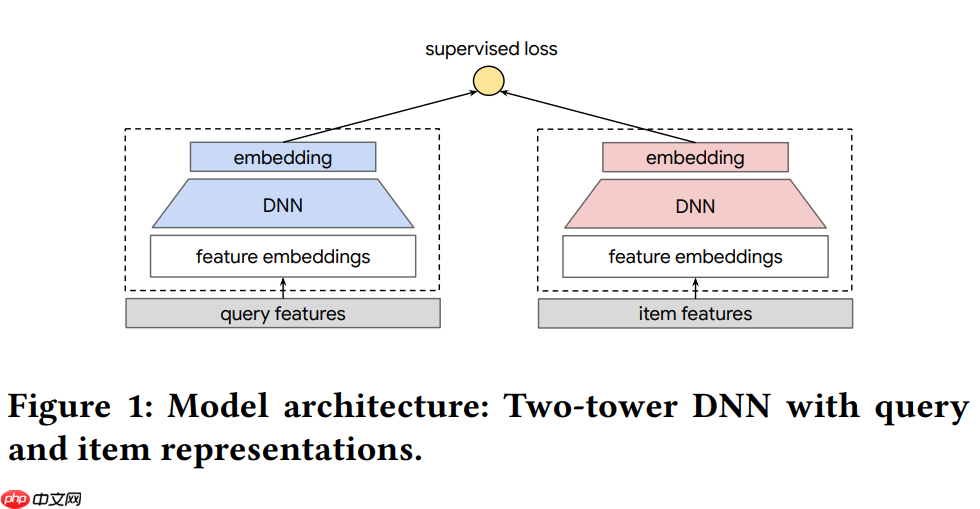

3.5 完成对比学习后,下一步是联合训练。论文中的模型图如下:

从图中可以看出,整个item tower是被user-item双塔召回的主任务、对比学习辅助任务中的encoder H和G所共享的。

论文的第二个重点是,“We sample items uniformly from the corpus for Lself”,论文中明确表示参与对比学习的样本和参与主任务的样本来自不同的样本空间。主任务需要拟合用户与商品之间的真实互动,仍以已经曝光过的user/item为主。对比学习部分是为了消除推荐长尾问题,主要关注曝光率低的商品。

参考资料:

[1] 石塔西:少数派报告:谈推荐场景下的对比学习:https://www.php.cn/link/9dd5b938ee55c873017b525aaf333882

[2] 推荐场景下的对比学习总结

[3] 基于对比学习的推荐算法总结

[4] self-supervised learning for large-scale item recommendations:https://www.php.cn/link/6e53ba571a5ed6223b77eeb7ca2c2e44