一种全新易用的基于词间关系的命名实体识别(ner)统一模型,刷新了14种数据集并达到新的最佳表现(sota)。这篇论文名为《unified named entity recognition as word-word relation classification》,已被aaai2022收录,详细内容可通过链接https://arxiv.org/pdf/2112.10070.pdf查看。

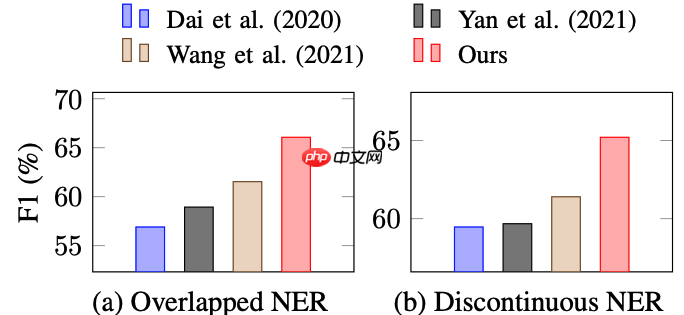

NER任务通常分为三种类型:平面NER(flat NER)、重叠NER(overlapped NER)和不连续NER(discontinuous NER)。近期的研究致力于通过一个统一的大模型来同时解决这三种问题。现有的最佳方法主要基于span-based和seq2seq的方法,但span-based方法需要枚举所有可能的span组合,存在时间复杂度问题;而seq2seq方法则容易产生错误传播。

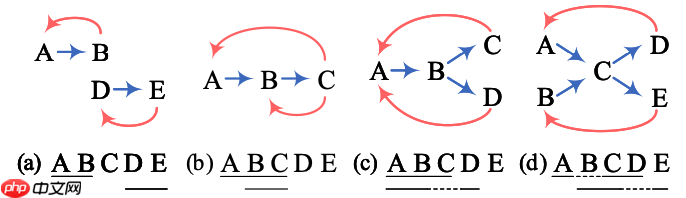

因此,本文提出了一种新颖的框架,通过预测词与词之间的关系(称之为W2NER)来解决所有NER问题。词间关系主要分为三种:下一邻居词关系(NNW)、尾部-头部词关系(THW-*)和无关系(NONE)。为了解决图的稀疏性问题,文章采用了一个多粒度的二维图来表示词间关系。

模型由三个主要模块组成:

-

卷积层(Convolution Layer):包含一个条件层归一化(CLN)层,用于获得词j在词i前提下的表示。接着是BERT风格的网格表示层,通过BERT的三个嵌入层获得信息表示、关系位置信息表示和位置域表示,并通过MLP融合。最后通过多粒度的空洞卷积(Multi-Granularity Dilated Convolution)采样不同的信息。

-

共同预测层(Co-Predictor Layer):使用一个普通的MLP和一个用于变长标签预测的biaffine预测器,最后通过softmax层输出结果。

解码层(Decoder Layer)通过NNW和THW-*构建实体环,如图所示:

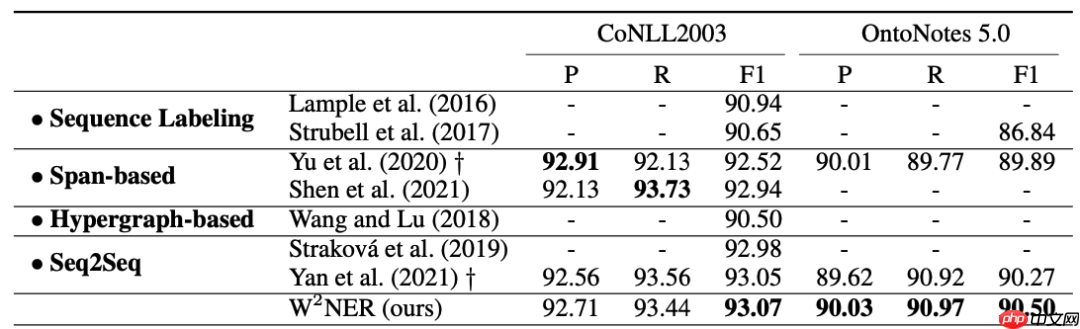

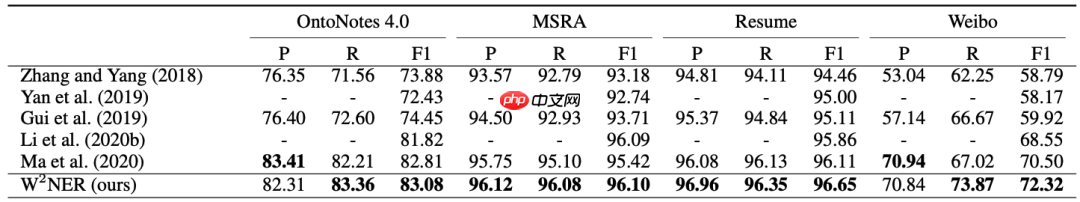

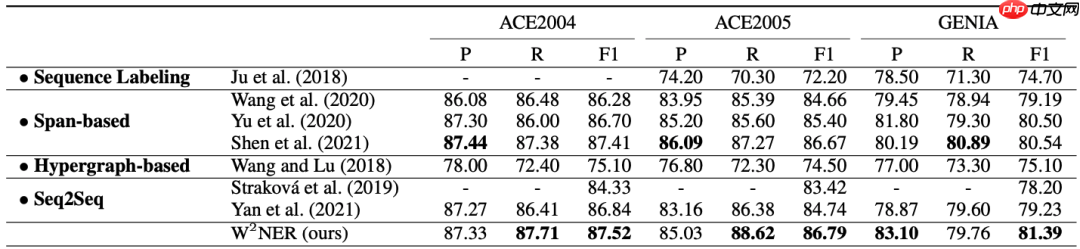

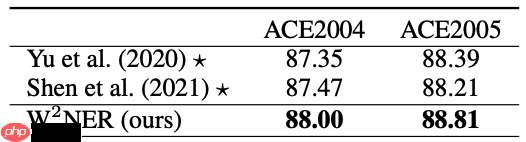

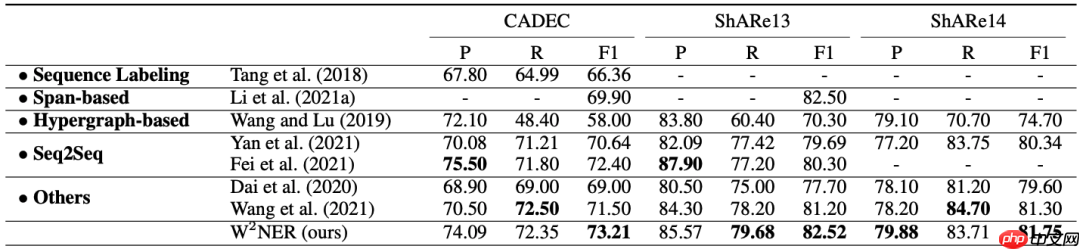

实验结果显示,该模型在14个公开数据集(包括中文和英文)上都取得了最佳表现,成为最新的SoTA。具体实验结果如下:

- 英文平面数据集:

- 中文平面数据集:

- 英文重叠数据集:

- 中文重叠数据集,F1性能:

- 英文不连续数据集:

与前沿最佳论文对比:

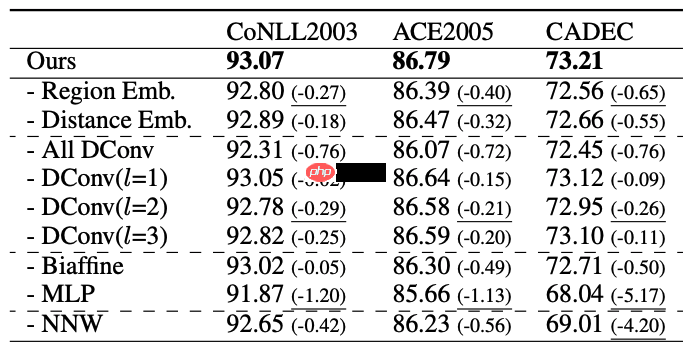

消融实验显示,F1性能:

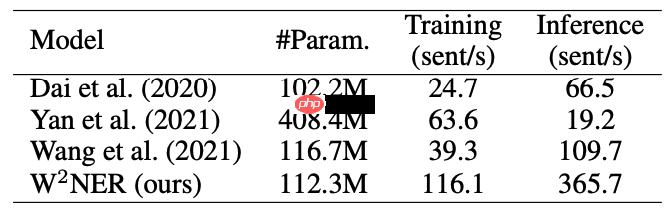

训练速度和推理速度也得到了极大提升:

总的来说,这篇文章提出了一个简单有效的NER新框架,具有较高的应用价值和潜力。